Você já parou pra pensar que aquele vídeo com uma “doutora famosa” indicando um suplemento milagroso pode ser completamente falso? E mais: que ela nem sequer existe? Pois é. Num mundo onde a inteligência artificial virou pincel para pintar autoridades fictícias, o cenário da divulgação científica virou território fértil para fraudes, enganos — e até crimes.

O jaleco agora é figurino, e o palco é digital

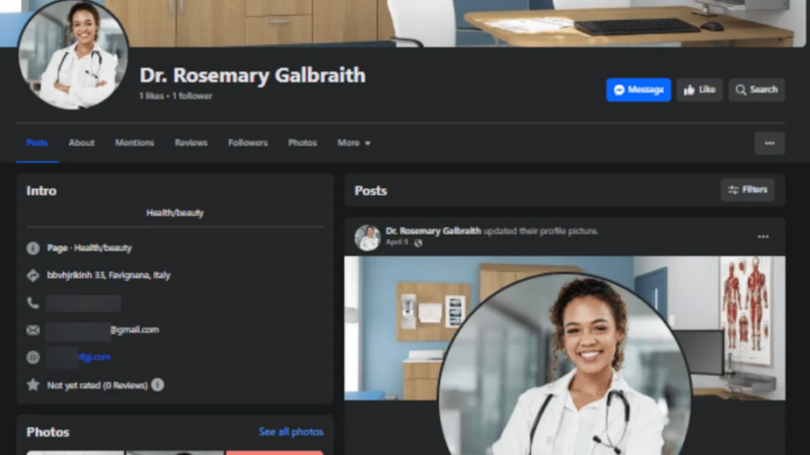

Nas redes sociais, perfis como o da suposta “Dra. Rosemary Galbraith” se multiplicam. Ela, que aparece sempre de jaleco branco, com a voz doce e pausada, fala sobre terapias “revolucionárias” em vídeos impecáveis. Mas há um pequeno detalhe: ela não é real. É um personagem criado por IA, parte de uma rede de mais de mil perfis fraudulentos detectados pela Meta. E o objetivo? Vender promessas embaladas de ciência, mas recheadas de mentira.

Não é só a foto que engana. A construção é pensada para parecer confiável: título acadêmico, sotaque elegante, visual clínico. Tudo falso. E o problema ganha contornos dramáticos quando percebemos que a falsa esperança vendida por esses vídeos pode custar caro. Tempo. Dinheiro. Saúde. E até a vida.

Vozes sequestradas, rostos clonados

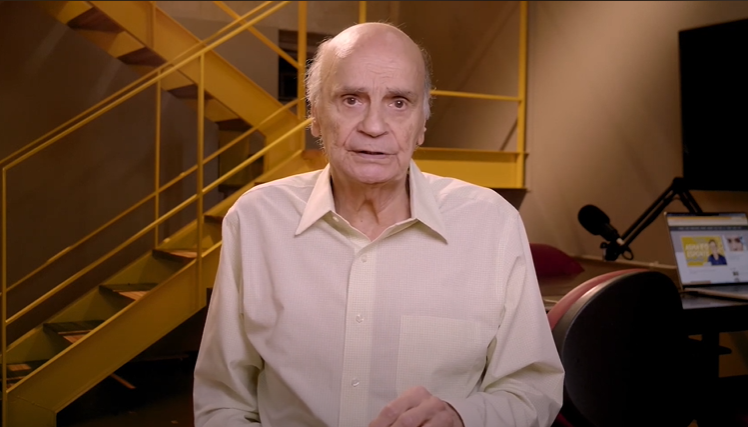

O caso do médico Drauzio Varella é um exemplo gritante. O rosto e a voz dele têm sido usados em vídeos forjados por IA para vender de tudo: colágeno mágico, curas para artrose, até “segredos da medicina natural”. Segundo o próprio Drauzio, mesmo acionando as plataformas, as respostas são escassas ou inexistentes. “Elas não dão bola”, desabafou ele.

Imagine: décadas de credibilidade jogadas no lixo por um clique. Uma vida dedicada à saúde sequestrada por um algoritmo ganancioso. E enquanto isso, as plataformas seguem lucrando com o engajamento desses conteúdos falsos.

Da África do Sul à Austrália, os golpes se espalham

Não é um problema isolado. A urologista Kgomotso Mathabe, na África do Sul, teve sua imagem usada para vender supostos tratamentos para disfunção erétil. Já Jonathan Shaw, endocrinologista australiano, foi alvo de deepfakes que usavam sua imagem para atacar colegas e promover produtos “milagrosos” para diabetes.

E não parou por aí. Norman Swan, jornalista de prestígio na Austrália, foi transformado digitalmente em garoto-propaganda de suplementos para doenças cardíacas. O vídeo era tão convincente que até colegas da emissora se confundiram. Resultado? Prejuízo estimado em mais de 2 bilhões de dólares num único ano.

E quando a estética científica é simulada?

Se a voz enganosa já é perigosa, imagine textos inteiros parecendo artigos científicos legítimos, mas escritos por IA? Pois isso já acontece. Ferramentas como ChatGPT, Gemini e Claude conseguem criar “papers” com títulos bonitos, linguagem técnica, gráficos, referências (falsas) e até DOI inventado.

Esses conteúdos são usados para promover desde dietas duvidosas até ideias negacionistas. Tudo com cara de estudo sério. A aparência é de autoridade acadêmica, mas a essência é pura enganação. É como usar jaleco em cena de teatro: a credencial é só figurino.

Crianças também são alvo da mentira embalada

Talvez o exemplo mais assustador venha do YouTube. Uma investigação da BBC revelou dezenas de canais infantis que simulam vídeos educativos, mas espalham pseudociência. Tudo feito por IA, com vozes sintetizadas, imagens vibrantes e linguagem simples. São os chamados “canais dark”.

Esses vídeos são recomendados logo após conteúdos confiáveis, confundindo o público infantil. O que era para ensinar, acaba programando confusão. Pirâmides mágicas, curas por frequências sonoras, distorções sobre biologia… O futuro está sendo manipulado na tela do celular.

A confiança virou moeda, e está sendo manipulada

A crise da divulgação científica não é apenas uma questão de conteúdos errados. É sobre o colapso da confiança. Quando o público não consegue mais distinguir ciência real de simulação bem feita, tudo vira opinião. E aí, o campo está livre para o negacionismo correr solto.

A confiança na ciência sempre foi construída com base em método, revisão por pares, correção e transparência. Mas agora, qualquer IA pode vestir o jaleco e fingir autoridade. E, pior: viralizar.

Quem deve proteger a verdade?

As plataformas digitais não são neutras. Se já conseguem detectar músicas com direitos autorais, podem sim detectar vídeos que imitam médicos ou pesquisadores. Falta vontade. Falta responsabilidade. E sobra omissão.

Vídeos, textos e vozes geradas por IA sobre saúde, meio ambiente ou educação precisam ser rotulados. De forma clara, auditável e visível. Porque isso não é arte. É falsificação. É usar uma farda que não se conquistou. E quem paga o preço é o cidadão comum.

Precisamos de uma nova alfabetização científica

Mais do que punir golpistas, é urgente ensinar as pessoas a duvidar do que parece ciência, mas não é. Mostrar que citação não é sinônimo de verdade, que gráfico bonito pode esconder mentira, que tom de voz pausado não garante rigor. A estética não pode substituir o método.

Alfabetizar cientificamente não é só ensinar biologia ou física na escola. É preparar o olhar para a era digital. Ensinar a distinguir entre o que foi estudado e o que foi só renderizado por IA. Se tudo parece ciência, até o absurdo, perdemos a capacidade de decidir com base na realidade.

O que está em jogo é mais que informação: é a democracia

A divulgação científica sempre foi um pacto democrático. Uma forma de tornar o conhecimento acessível e combater desigualdades. Mas agora, esse pacto está sendo rompido pela IA usada de forma irresponsável.

Quando tudo vira aparência de ciência, perdemos não só a verdade, mas também a possibilidade de aprender, confiar e evoluir. A IA não precisa mentir para desinformar. Basta gerar ruído suficiente até que ninguém saiba mais no que acreditar.

E num mundo onde o que mente melhor é o que viraliza, a ciência real corre o risco de ser silenciada pelo espetáculo da simulação. A verdade não é tendência. Mas é a única base segura para decisões que importam.

Fonte: cenariomt